同行1800多公里,跟着货车司机跑长途(人民眼·货车司机

图①:山西临汾经济技术开发区兴荣供应链有限公司的货车整装待发。资料图片 图②:司机王勇平驾驶货车行驶在

(资料图)

(资料图)

近年来,随着深度学习技术的发展和智能车辆技术的日益成熟,基于强化学习的自动驾驶技术备受关注。在强化学习中,基于策略的方法在处理连续控制命令时表现更为优秀,而基于价值的方法则更适用于提供离散命令。因此,针对自动驾驶这一连续控制过程,基于策略的方法更能发挥其优势,具有在高维动作空间中实现高天花板的潜力,表现出更好的收敛性和探索性。

针对自动驾驶的挑战,学者们进行了大量的研究。例如,Kendall等人利用深度确定性策略梯度(DDPG)算法在实际的智能车辆上进行探索和优化,在车上执行所有任务,并且通过学习车道跟随策略,成功地实现了人类水平的性能。而Wang等人则提出了一种基于人类专家的车道变更政策的创新方法,以帮助车辆顺利变道,无需V2X通信支持。

为了缓解自动驾驶在拥堵道路上的挑战,Saxena等人采用近端策略优化(PPO)算法来学习连续运动规划空间中的控制策略。他们的模型隐含地模拟了与其他车辆的互动,以避免碰撞并提高乘客的舒适度。Ye等人则利用PPO在真实的高速公路场景中学习自动变道策略。以自车及其周围的车辆状态为输入,智能体学会避免碰撞并以平稳的方式驾驶。而其他研究则证明了基于PPO的RL算法在端到端自动驾驶策略学习中的有效性。

虽然从头开始训练自动驾驶的策略通常是耗时且困难的,但与模仿学习(IL)和课程学习等其他方法相结合,可以获得更好的效果。例如,Liang等人将IL和DDPG结合在一起,以缓解在探索连续空间时效率低的问题,并引入了一种可调节的门控机制来选择性地激活四个不同的控制信号,这使得模型可以由中央控制信号控制。而Tian等人则利用从专家经验中学习的RL方法来实现轨迹跟踪任务,该任务分两步进行训练,即中采用的IL方法和连续的、确定性的、无模型的RL算法来进一步改进该方法。

另一方面,为了提高RL方法的学习效率,学者们开始将人类先验知识纳入RL方法中。例如,Huang等人设计了一种新方法,将人类先验知识纳入RL方法,以解决自动驾驶的长尾问题。而Wu等人提出了一种基于人工引导的RL方法,该方法利用一种新的优先体验重放机制来提高RL算法在极端场景下的效率和性能。该方法在两个具有挑战性的自动驾驶任务中得到了验证,并取得了有竞争力的结果。

综上所述,基于强化学习的自动驾驶技术是当前的研究热点之一。在此过程中,基于策略的方法更适用于连续控制命令,具有更好的表现和潜力。针对自动驾驶的挑战,学者们采用各种算法和方法来实现自动驾驶。从模仿学习到课程学习,再到结合人类先验知识的RL方法,这些技术都有望提高自动驾驶的效率和性能。未来,随着技术的不断发展和完善,基于强化学习的自动驾驶技术将会得到更广泛的应用和推广。

标签:

图①:山西临汾经济技术开发区兴荣供应链有限公司的货车整装待发。资料图片 图②:司机王勇平驾驶货车行驶在

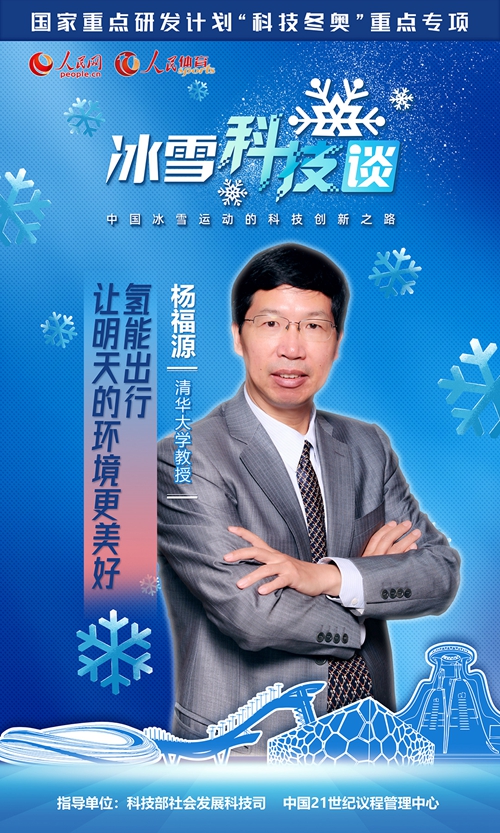

2022年北京冬奥会的筹办过程,为中国冰雪运动发展提供了巨大动力。科技创新,成为中国冰雪运动前进道路上嘹亮的号角。在科学技术部社会发展

游客在银川市黄河横城旅游度假区观看花灯展(2月5日摄)。春节假期,“2022黄河横城冰雪彩灯艺术节”在宁夏银川市

新华社香港2月6日电题:狮子山下的舞狮人新华社记者韦骅“左眼精,右眼灵,红光万象,富贵繁荣!”“口食八方财,

正在进行围封或强制检测的葵涌邨居民在登记(资料照片)。新华社发新华社香港2月6日电 题:凝聚香港社会共克时艰

2月6日,航拍青海省西宁市雪后美景。受较强冷空气影响,2月5日至6日,青海迎来大范围降雪天气过程,古城西宁银装

[ 相关新闻 ]